基于Hadoop的数据去重技巧

在Hadoop平台上进行数据去重是一项常见的任务,它可以有效地处理大量数据,减少数据的冗余度,节省存储空间,简化计算逻辑,提高处理效率,并产生更精准可靠的数据。以下是基于Hadoop的数据去重的一些主要技巧和方法:

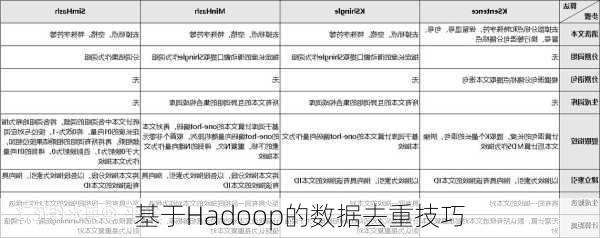

Hive提供了一种简单的方法来实现数据去重,即使用`DISTINCT`关键字。这可以通过对SELECT查询的结果进行去重,返回唯一的记录行来实现。需要指定去重的列,可以是一列或多列。底层依赖HDFS数据的HashPartitioner进行分区与排序。

另一种方法是在MapReduce中自定义Partitioner或SortComparator进行去重。在Partitioner中,可以通过哈希分区按指定列进行数据划分。在SortComparator中,可以指定排序列以排序相同的记录。在Reduce阶段,可以通过过滤相邻的重复记录实现去重。

这种方法涉及到使用CombineFileInputFormat以小文件为单位进行输入数据的合并。在Reduce端,再对合并后的大文件进行去重操作。这可以减少Map端的处理量,从而提高效率。

BY与HAVING实现去重

这是一种适用于数据已入库至MySQL/Hive/Impala等系统中的方法。通过使用GROUP

BY对指定列进行分组,然后HAVING过滤count=1的组实现去重。这支持多列组合进行去重,但性能可能会有一定的损失。

此外,还可以通过编写MapReduce程序来实现数据去重。在这个过程中,可以在Map阶段将数据作为key,而value设置为任意值,然后在Reduce阶段,不管每个key有多少个value,都直接将输入的key***为输出的key,并输出空值。这种方法需要深入理解MapReduce的编程模型和工作原理。

以上就是在Hadoop平台上进行数据去重的一些主要技巧和方法。在实际应用中,可以根据数据的特点和处理需求选择合适的方法。