HDFS块分配原理

HDFS(Hadoop

Distributed

File

System)是一种分布式文件系统,用于存储和处理大量的数据。在HDFS中,文件被分割成多个块,并且每个块都有多个副本存储在不同的DataNode节点上。这种设计的主要目的是为了实现数据的高可靠性和负载均衡。

块的划分

在HDFS中,文件被划分为多个块。每个块的大小可以通过配置参数`dfs.blocksize`来设定,默认大小为128MB或64MB。这样的设计主要是为了平衡寻址时间和传输时间。如果块设置得足够大,从磁盘传输数据的时间会明显小于定位这个块开始位置所需的时间。

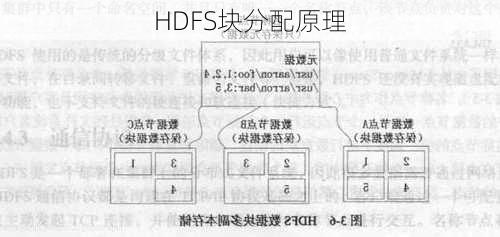

副本的存放策略

HDFS采用机架感知和副本均匀分布的策略来存放数据块的副本。这意味着在分配副本时,会优先考虑存储相同副本的DataNode节点是否位于同一个机架上,以减少网络延迟。默认情况下,一个块的副本分布在三个不同的DataNode节点上。

块的分配流程

当一个文件需要在HDFS上写入时,HDFS会首先在客户端处将文件切分成多个块。然后,NameNode会随机选择一个节点作为目标节点,并判断该节点是否符合存储数据块的条件。如果目标节点符合条件,那么第一个块副本就会被分配到该节点上;否则,会在集群范围内重新选择目标节点。

容错性

由于每个块都有多个副本,因此即使某个DataNode节点发生故障,也不会导致数据的丢失。当NameNode检测到某个块的副本数量不足时,会在另一个节点上创建一个新的副本。

总结

HDFS的块分配原理主要包括以下几个方面:首先,文件被划分为多个块,块的大小可以通过配置参数进行设定;其次,每个块都有多个副本存储在不同的DataNode节点上,副本的存放采用机架感知和副本均匀分布的策略;最后,当需要写入文件时,会选择合适的DataNode节点作为副本的存放地,并且在必要时,会自动创建新的副本以保证数据的安全性。这种设计使得HDFS能够有效地处理大规模的数据,并且具有很高的容错性。